计算机科学与技术学院(贵州保密学院)张永军团队最新研究成果在人工智能领域顶级期刊Pattern Recognition上发表

发布时间: 2025-06-23 | 查看数:10

近日,张永军老师团队在模式识别领域国际顶级期刊《Pattern Recognition》(中科院一区TOP期刊,模式识别与人工智能领域顶级期刊之一)上发表题为“Leveraging negative correlation for Full-Range Self-Attention in Vision Transformers”的学术论文,展现了团队在模式识别和图像处理领域的深厚学术积累与前沿创新能力。论文第一作者为2021级硕士研究生龙伟,通讯作者为张永军老师。贵州商学院为共同单位。

自注意力机制在图像分类、目标检测和图像分割等计算机视觉任务中具有重要作用,但现有方法在特征提取上仍存在一定局限性,主要表现为只能捕捉图像中的正相关特征,忽略了特征之间的负相关性。这使得基于自注意力机制的深度学习模型在高维语义信息提取和特征区分上存在明显不足,特别是在处理复杂对象特征时无法有效进行精准识别。此外,自注意力机制在反向传播过程中容易出现梯度消失问题,从而影响模型优化,现有方法仍然存在注意力权重分布过于均匀导致特征区分度降低,不利于特征识别和提取。

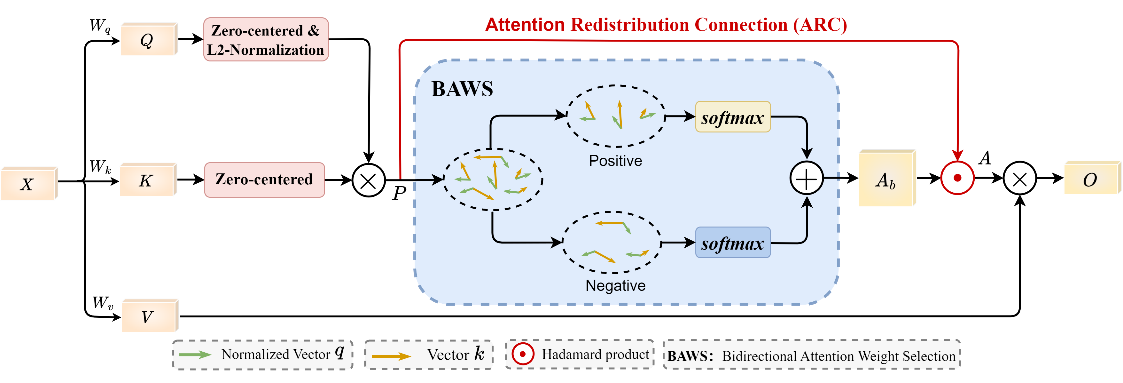

全范围自注意力结构图

针对这一难题,张永军老师团队创新性地提出了全范围自注意力(FSA)方法,通过引入负相关特征,有效扩展了原有自注意力的相关性表示范围。此方法能够使模型能够同时捕捉正向和负向的相关性特征,从而更精准地区分相关和无关的图像特征。此外,改研究还创新性地设计了双向注意力权重选择(BAWS)策略,帮助模型在识别和聚焦最相关的特征的同时排除掉与任务无关的负相关性特征。此外,还通过引入注意力重分配连接(ARC),使得模型能够动态调整注意力强度,优化特征聚合,避免梯度消失问题的发生。该方法能够在不增加额外的计算开销和参数量的情况下,显著提升模型的特征提取能力和语义理解能力。

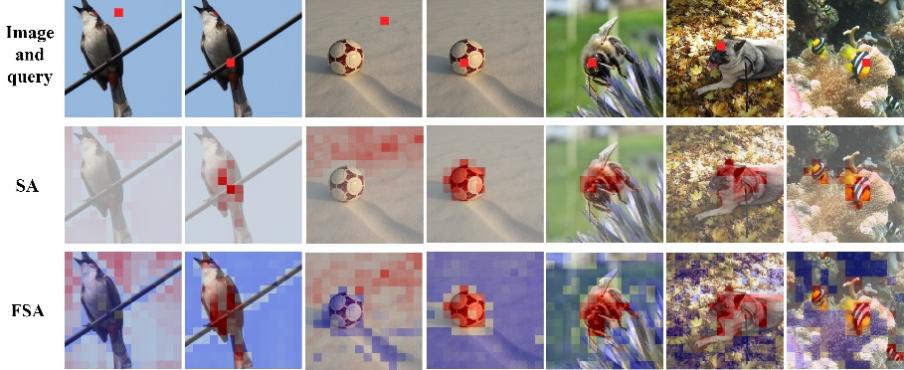

注意力分布可视化效果图

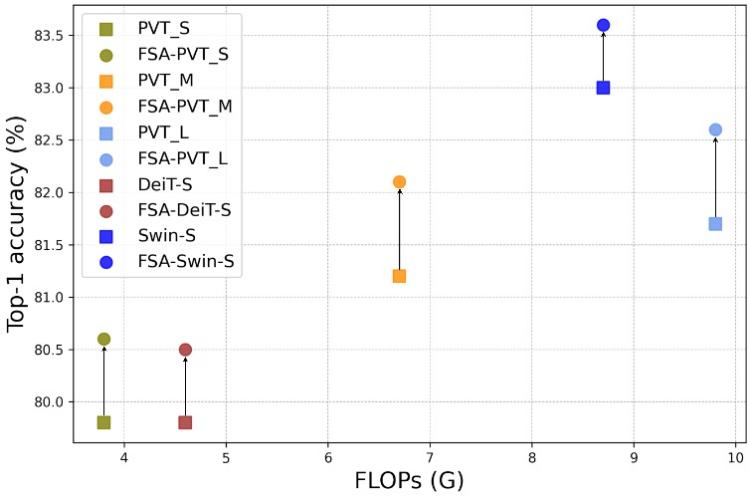

实验结果表明,提出的全范围自注意力在多个计算机视觉重要任务和先进模型中显著提升了性能。在ImageNet-1K分类中,全范围自注意力在不增加计算成本的情况下,大幅提高了多种Vision Transformer模型的准确性。在COCO目标检测和实例分割中,由全范围自注意力改进过后的方法检测性能明显优于原始的模型。在ADE20K语义分割任务中,引入全范围自注意力后的方法在mIoU指标上提升了1.6%至2.4%。与现有注意力机制相比,全范围自注意力的核心突破在于成功挖掘了长期被忽视的负相关性特征交互机制,在保持相同参数量和计算复杂度的基础上,显著提升了多个先进的Vision Transformer模型在多个计算机视觉基础任务中的性能。

在不增加计算量情况下的效果提升对比图

论文名称:Leveraging negative correlation for Full-Range Self-Attention in Vision Transformers

论文链接: https://doi.org/10.1016/j.patcog.2025.111899

一审:唐玮欣

二审:何 飞

三审:龙慧云