贵州省首篇:ACL2025录用我院文本计算与认知智能教育部工程研究中心团队科研论文

发布时间: 2025-05-18 | 查看数:10

近日,我院文本计算与认知智能教育部工程研究中心科研团队题为“Exclusion of Thought: Mitigating Cognitive Load in Large Language Models for Enhanced Reasoning in Multiple-Choice Tasks” 的研究论文被自然语言处理领域顶级国际会议ACL 2025 (The 63nd Annual Meeting of the Association for Computational Linguistics,CCF-A类) 录用。这是我省高校及科研机构首篇被ACL录用的论文,也是我省大语言模型(Large Language Models, LLMs)领域首篇国际顶级会议论文,标志着我院在认知智能与自然语言理解研究方面取得了重要突破。论文第一作者为我院2023级研究生付启航,通讯作者为秦永彬教授和黄瑞章教授。

ACL(国际计算语言学年会)是自然语言处理与计算语言学领域最高级别的学术会议,由国际计算语言学学会主办。国际计算语言学学会是世界上影响力最大、最具活力的国际学术组织之一,它每年夏天都会召开ACL年会,是NLP领域最高级别的国际学术组织,代表了国际计算语言学的最高水平。ACL是自然语言处理(NLP)领域的顶级学术会议之一,ACL论文通常代表了该领域的前沿研究成果。今年被称为ACL论文收录竞争最为激烈的一年。前段时间,ACL曾公布了今年总投稿数,高达8000多篇,创历史之最,而去年的投稿数为4407篇。

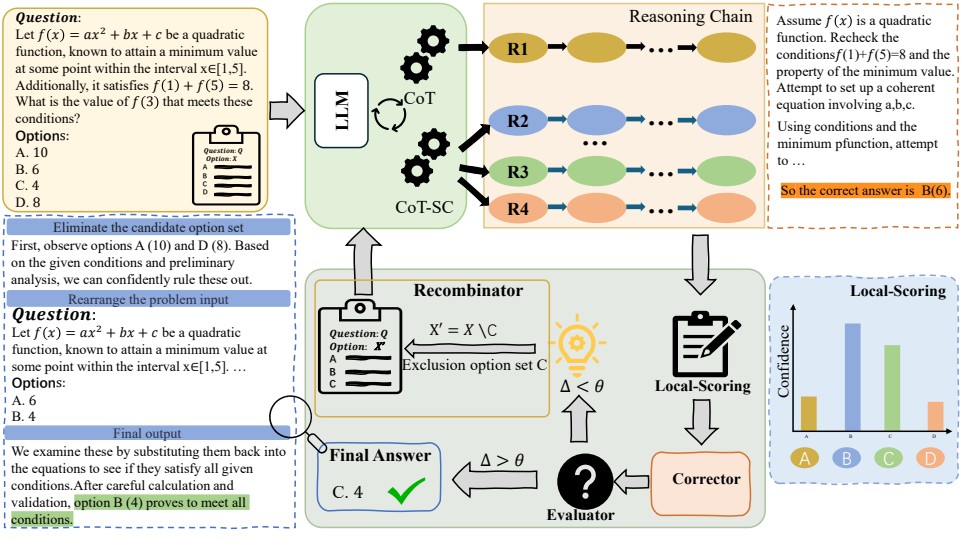

随着以GPT-4、DeepSeek等为代表的大语言模型技术迅速发展,LLMs已成为当前人工智能领域的核心研究方向之一。依托海量参数与强大的语言建模能力,LLMs在文本生成、问答、翻译等多个自然语言处理任务中展现出卓越表现。然而在面对多项选择题任务时LLMs往往会受到错误选项的影响,错误的选项会对模型的理解和推理能力产生“认知负担”,导致LLMs时常给出看似正确但实则错误的答案。为应对这一难题,本文提出了模拟人类思维方式的大语言模型推理方法,简称Exclusion of Thought(EoT)。该方法通过引导大语言模型主动排除错误选项,从而有效降低外部干扰对模型推理路径的影响,显著减轻其“认知负担”。同时,EoT策略通过记录模型的排除过程,增强了其推理过程的透明性与可解释性,为解决当前人工智能“黑盒问题”提供了新的思路。

EoT作为一种即插即用的方法,可以与现有的任何一种提示策略相结合。本文在6个多项选择题数据集和5个热门的LLM上进行了广泛而全面的实验。结果显示,EoT显示出一致的性能提升,在传统方法表现欠缺的复杂推理任务上提升更为明显。

此次论文成功入选ACL主会,充分展示了我院在人工智能领域,特别是认知智能与语言推理方面的科研实力,也彰显了近年来我院强化计算机科学学科及人工智能科研团队建设的成效。

贵州大学文本计算与认知智能科研团队最早组建于2008年,经过十几年的建设与发展,形成了从事文本挖掘与分析、自然语言处理、知识融合、认知智能、医学影像、数据智能等相关研究的特色科研团队。2022年,获批文本计算与认知智能教育部工程研究中心。目前聚焦互联网文本分析、认知分析、法律大模型、智慧法院、智慧司法、医学影像分析与精准诊断等人工智能的交叉领域开展研究与应用。工程研究中心现有博士生导师6人,硕士生导师15人,研究生200余人(其中博士20余人)。工程中心科研团队主持承担国家重点研发计划1项,国家自然科学基金7项,贵州省科技重大专项1项,贵州省科技成果转化重大项目1项,贵州省重大应用基础研究计划项目2项,贵州省科技重点专项3项,贵州省自然科学基金重点项目3项,贵州省自然科学基金5项。各类竞赛获奖100余项,获专利近20项。产学研合作企业10余家。

我院文本计算与认知智能教育部工程研究中心科研团队将继续秉承“前沿引领、交叉融合”的科研理念,持续加强在自然语言处理与认知智能等关键方向的研究投入,努力打造高水平、有特色的人工智能科研平台,服务国家战略需求和人工智能产业发展。

一审:唐玮欣

二审:何 飞

三审:龙慧云